Exabeam biedt oplossingen voor security intelligence en beheer om organisaties te helpen hun meest waardevolle informatie te beschermen. Het Exabeam Security Intelligence Platform combineert op unieke wijze onbeperkte gegevensverzameling, machine learning voor geavanceerde analyses en geautomatiseerde incident respons in een geïntegreerde set van producten.

De missie van het Security Operations Center (SOC) is het beschermen van de gegevens van de organisatie, evenals de gegevens en privacy van gebruikers. Om dit te bereiken, zijn tools, systemen en oplossingen nodig die betrouwbare informatie analyseren en produceren; voldoen aan de regelgeving inzake gegevensbescherming en privacy; en zich niet onvoorspelbaar of onregelmatig gedragen.

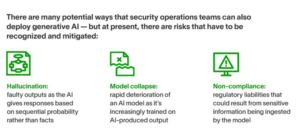

Kunnen de nieuwste kunstmatige intelligentie (AI) tools en toepassingen voldoen aan deze criteria in hun huidige versies? Niet altijd, daarom moeten SOC’s zich bewust zijn van de adoptie van deze technologieën in hun organisaties en bij toenemend gebruik in beveiligingsactiviteiten.

In dit artikel:

- Gluren in de black box

- Hoe hallucinaties ontstaan

- Wat is model collapse?

- Zijn er transparante modellen?

Gluren in de black box

Technologieën zoals generatieve AI worden aangedreven door grote taalmodellen (LLM’s), die worden getraind op enorme datasets die meestal zijn verzameld van over het hele web. Sterker nog, deze datasets zijn zo gigantisch dat het moeilijk is om te weten welke gegevens het model heeft opgenomen, en het is ook niet mogelijk om te volgen wat er met gegevens gebeurt die in het model terechtkomen.

Daarom kun je dit type AI vergelijken met een zwarte doos — of misschien zelfs een zwart gat, aangezien eenmaal data in het model terechtkomt, het er niet meer uit kan worden gehaald.

Datawetenschappers maken al grote vooruitgang in het afbakenen van wat modellen wel en niet kunnen opnemen, en generatieve AI-modellen die speciaal zijn ontworpen voor specifieke sectoren en gebruiksscenario’s kunnen helpen bij het opleggen van grenzen. Er kunnen echter nog steeds beveiligingsimplicaties zijn bij het werken met ondoorzichtige systemen en processen. Beveiligingsteams moeten zich hiervan bewust zijn bij het gebruiken en monitoren van AI, evenals bij het beoordelen van de controles die worden gebruikt door potentiële leveranciers van oplossingen.

Een risico is bijvoorbeeld het lekken van gegevens, waarbij gevoelige of bedrijfseigen informatie wordt opgenomen in het model; dit kan regelgevende gevolgen hebben voor organisaties. Maar een ander risico komt voort uit het feit dat als je niet weet wat er in het model is gegaan, je niet kunt vertrouwen op wat eruit komt — vandaar de goed gedocumenteerde uitdagingen van AI-hallucinatie.

Hoe hallucinaties ontstaan

Wanneer je een tekstbericht verzendt, heb je misschien gemerkt dat je smartphone voortdurend suggesties doet voor het volgende woord dat je zoekt. Dat kan een relatief eenvoudige toepassing van machine learning (ML) zijn, maar het verschilt niet wezenlijk van wat er gebeurt wanneer je een toepassing zoals ChatGPT gebruikt.

Terwijl je generatieve AI automatisch tekst produceert, raadpleegt het niet een enorme gegevensopslag om je een objectieve, controleerbare waarheid te bieden; in plaats daarvan voorspelt het het volgende meest waarschijnlijke woord in de context van je vraag. Daarom kan het vreemde zijpaden inslaan waarin de AI zelfverzekerd en autoritair onzin produceert, wat bekend staat als hallucinatie.

Voor leken kan dit op zijn best amusant zijn en op zijn slechtst onhandig. Maar voor beveiligingsanalisten, die snelle beslissingen moeten nemen op basis van nauwkeurige inzichten, is het essentieel dat eventuele generatieve AI-tools die ze inzetten, beschermd zijn tegen dit risico en aangeven wanneer ze onvoldoende informatie hebben in plaats van deze te verzinnen.

Wat is model collapse?

Een andere reden tot zorg is model collapse, wat de neiging is van de kwaliteit van de outputs van een generatief AI-model om verrassend snel achteruit te gaan, naarmate door AI gegenereerde inhoud steeds meer aan het model wordt toegevoegd.

Dit komt voort uit de eerder genoemde neiging van generatieve AI om outputs te leveren op basis van waarschijnlijkheid in plaats van echte waarheid. Door AI gegenereerd materiaal gaat snel voorbij aan en verliest minderheidskenmerken die aanwezig zijn in de data, wat betekent dat naarmate dit materiaal wordt opgenomen in modellen, ze steeds minder representatief worden voor de werkelijkheid.

Zijn er transparante modellen?

Traditionele machine learning vereist doorgaans dat datawetenschappers modellen bouwen en trainen voor specifieke gebruiksdoelen, wat betekent dat ze doorgaans verantwoordelijk zijn voor wat er in het model gaat en wat er aan de andere kant uitkomt. Niet verrassend heeft ML, en zijn meer geavanceerde variant, deep learning, de meest betrouwbare AI-oplossingen voor de cybersecurity-ruimte aangedreven en wordt al jaren gebruikt om immense hoeveelheden informatie te analyseren en patronen te identificeren.

Exabeam maakt gebruik van hun op AI gebaseerde Security Operations Platform met AI in ML om alles mogelijk te maken, van het toekennen van dynamische risicoscores aan User and Entity Behavior Analytics (UEBA), die de normale activiteiten van een organisatie begrijpt om effectief afwijkingen te markeren. Dergelijke AI-capaciteiten blijven essentieel, zelfs nu generatieve AI nieuwe manieren ontdekt om verdedigingen te versterken, en ze blijven vooral cruciaal wanneer generatieve AI wordt gebruikt om aanvallen te versterken. Download de CISO’s Guide to the AI Opportunity in Security Operations voor een grondiger onderzoek van deze verschuivingen.

Meer weten over Exabeam AI? Neem dan contact op met Exclusive Networks op +31 (0)499 462121 of stuur een e-mail naar info@exclusive-networks.nl